Недавно узнал об одной очень удобной функции в Gnome. Если зажать на клавиатуре Alt и левую кнопку мыши в любом месте активного окна, то окно можно перемещать, если оно не развёрнуто на весь экран. Это очень удобно при работе с нетбука, так как иногда окна настроек по вертикале больше нежели 600 пикселей.

Рубрика: Linux

Внедрение СПО в школах под угрозой

Уважаемое сообщество! Обращаюсь к вам за помощью. К сожалению, несмотря на все заявления Д.Медведева и других руководителей о поддержке курса перехода на СПО, в реальности происходит торможение, а по сути, свертывание этого процесса. ЦеСТ пытается препятствовать этому, но мы не всесильны. Даже запросы депутатов Госдумы по этому поводу не дали результата. В настоящее время происходит просто расхищение бюджетных денег, выделенных на СПО.

Подробнее об этом можно прочитать в блоге у Алексея Новодворского и у Виктора Алксниса.

На наш взгляд осталась последняя возможность — привлечь общественное внимание к этой проблеме. Именно поэтому я обращаюсь к вам за помощью и прошу принять участие в пропаганде кампании по внедрению СПО в школы. На первых порах для этого надо максимально разместить информацию о происходящем на различных форумах и в блогах.

Кстати о блогах. У кого они есть, просьба дать у себя ссылки на вышеприведенные посты, чтобы вывести их в ТОП Яндекса.

Просьба также писать о саботаже школьного проекта в блог Медведева.

Чем больше мы вместе будем об этом говорить, тем больше шансов защитить внедрение СПО. Поймите, если школьный проект провалится (к чему идет дело), то будут провалены и планы перехода нашей страны на СПО.

Вне зависимости от наших разногласий по тем или иным вопросам, сегодня самое главное спасти школьный проект. Спасем его, значит Linux в России победит!

Linux & Lotus. Единство великих.

В наше непростое время каждое предприятие ищет способы снизить затраты. Делать это следует конечно всегда, но самое главное — не в ущерб работе.

Для тех, кто использует продукты IBM категории Lotus, а точнее Lotus Domino и Lotus Notes, до недавнего времени были всего две реальные альтернативы в плане платформы для установки серверов и клиентов. Это либо AIX от IBM, либо Windows Server. И то и другое стоит денег и весьма приличных. Но на данный момент есть превосходная альтернатива, ничем не уступающая по производительности, а даже в чем то превосходящая.

Как вы уже догадались — это операционная система Linux.

Читать дальше

Это страшное слово – «виртуализация». Часть третья, заключительная. У страха глаза велики.

Итак, настал момент истины, и я пишу заключительную часть про виртуализацию.

Для тех, кто не в курсе, здесь первая часть (в которой я описываю, с чего все началось и как сделать), здесь вторая часть (в которой я предостерегаю от некоторых технических ошибок). Ну а сейчас пойдет речь о том, что же делать, если приходится переустановливать систему (к примеру мигрируя на другую платформу) и напоследок небольшая фотосессия.

Итак, с чего же я начну… Став счастливым обладателем еще 4Гбайт оперативной памяти, 2-х терабайтников от WD и пары вентиляторов, я пришел к мысли, что надо не просто поставить все это в сервер, но и заодно воспроизвести ситуацию с переустановкой системы.

Для начала напомню и дополню свою конфигурацию сервера:

— процессор AMD Phenom X4 9550 SocketAM2+ (2.20GHz, 4Mb, 1800MHz) (я сторонник AMD, так уж вышло);

— плата MB ASUS sAM2+ M3A78 AMD 770 DDR2 ATX (выбирал по доступности и с наличием RAID, что в итоге оказалось не совсем корректным, читайте в первой части);

— оперативная память 8Гбайт (всего четыре планки по 2Гб, максимум для материнки);

— жесткие диски, 4 по 1Тб (объединены по два в RAID-1, один на более отказоустойчивых для активной работы, второй на попроще дисках для малоиспользуемых файлов относительно первого);

— операционная система Debian Lenny x86_64.

Перед тем, как переустанавливать, я естественно сохранил настроечные документы. И вы не забудьте тоже их сохранить, дабы заново не изобретать велосипед.

Что же изменилось, помимо добавления в аппаратной начинке? А изменению у меня подвергнутся виртуальные настройки. Я заранее распределю на разные сетевые карты виртуалки по признаку активности с внешним миром, повесив на отдельную сетевую карту внешние. Описывать там особо нечего, кроме того, что для этого я создал два бриджа, вместо одного и при настройке виртуальной машины прописывал нужный бридж. Плюс ко всему я перетаскиваю rtorrent с виртуальной на хостовую машину, т.к. столкнулся с неприятными особенностями работы nfs при большом кол-ве открытых файлов. Количественно это может и не много, около 200 одновременно открытых файлов, но от этого начинались жуткие тормоза раздачи, что меня не устраивало.

Как установить чистую систему, не потеряв нужных данных, вы и без меня знаете наверняка. Остановлюсь на важных и болезненных моментах, по моему мнению:

— виртуальные машины воспроизвелись без проблем, путем простого наката папки /etc/libvirt из бекапа (изменения вступили в силу после перезагрузки, единственное что поправил — это пути до образов жестких дисков и названия бридж-интерфейсов);

— при настройке второго рейда не торопитесь его использовать, лучше дождитесь окончательной синхронизации (хотя пользоваться им можно и сразу, но из-за фоновой синхронизации будут ощутимые потери в производительности).

Хм… что-то мало болезненных моментов, не правда ли? Ну так не забываем, что перед нами операционная система Linux, которая гораздо гибче и стабильнее Windows, так что сомнений быть больше у Вас не должно. В остальном никаких проблем не возникло, так что смело можете при необходимости переставлять систему, не боясь потерь.

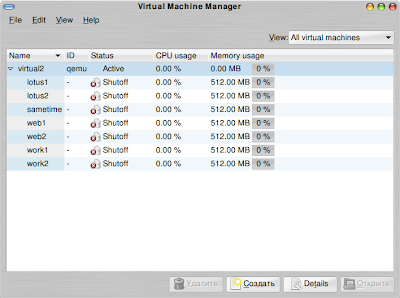

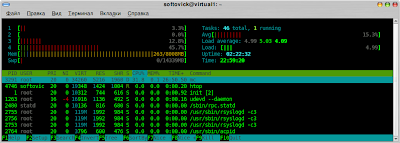

Напоследок несколько фото, как выглядит в живую и со стороны ПО мой сервер (за качество не ругайте, снято на коммуникаторе):

Это страшное слово – «виртуализация». Часть вторая. Не повторяйте чужих ошибок.

Получив в распоряжение мощный инструмент в виде сервера виртуализации я сразу попытался по максимуму его задействовать в своих задачах.

Попользовав его в достаточном количестве, обнаружил некоторые тонкости и нюансы, которыми и хочу с вами поделиться.

1. Если предполагаете использовать серверы раздельно для сети и для интернета, лучше сразу запланировать/приобрести/настроить минимум две сетевые карты. Во-первых, работать будет шустрее. После разделения на две сетевые карты скорость по внутренней сети стала около 10Мбайт/с, тогда как в случае единственной сетевой карты скорость скакала от 2 до 6Мбайт/с. Во-вторых, как выяснилось, на уже настроенной на один интерфейс виртуальной машине при смене активного интерфейса начинаются непонятные явления, потери пингов и т.п. (Windows Server вообще потерял сеть, например, а rtorrent просто зависал).

2. Разделяйте на разные физические разделы данные, используемые с ощутимо разной интенсивностью. Т.е. если вы планируете раздавать файлы по пиринговой сети, ftp и локальной сети, то лучше сохранять эти файлы на отдельном разделе, по минимуму смешивая с теми, которые используются другими виртуальными машинами. Благо современные средства монтирования файловых систем позволяют в одну папку монтировать одновременно несколько физических разделов.

3. Если вы используете в качестве гостевой системы Linux, то по возможности приближайте ее к варианту, который стоит на хосте. Т.е. в моем случае это Debian Lenny. Сервер LAMP+FTP+Ubuntu работал относительно нестабильно в плане сетевой активности, в отличие от связки LAMP+FTP+Debian…

4. Если планируется очень большая активность файловых операций (типа раздача более 100 торрентов одновременно), то советую в этом случае отказаться от использования виртуальной машины и настроить сервер непосредственно на хосте. Это позволит избежать значительных потерь в производительности (к примеру хешироваться файл для торрент-раздачи на хосте будет раз в 10 быстрее, чем в виртуальной машине через nfs).

Это страшное слово – «виртуализация». Мое решение на базе KVM.

Заметка пригодится всем, кому интересно использовать виртуализацию в своей работе. Мое решение вполне может претендовать на промышленное применение и пригодится тем, кто захочет сократить расходы на аппаратную часть при необходимости иметь в наличии разветвленную сетевую инфраструктуру. На подобном варианте базируется некоторые решения от IBM, к примеру. Но эти решения далеко не бюджетные и востребованы лишь в исключительных случаях.

Итак, однажды мне понадобилось в домашних условиях воспроизвести разветвленную сетевую инфраструктуру, состоящую из различных программных платформ. Путь начинался от VMWare Workstation и завершился KVM… Почему именно KVM и как все было, читайте ниже.

1. Немного истории или с чего все началось.

Работая в банке, я вживую столкнулся с виртуализацией. Это была операционная система AIX от IBM, работающая на майнфреймах. С самого начала меня поразила мощь и гибкость подобного подхода. И когда мне понадобилось воспроизвести в тестовых целях дома разветвленную программную инфраструктуру, то сразу базировал все это на принципах виртуализации. Это позволило избежать как значительных затрат на аппаратную часть, так и уместить все весьма компактно в плане пространства.

Для читателя следует учесть, что на самом деле инструментов виртуализации великое множество. Каждый из них имеет свои тонкости и нюансы. Я же ставлю цель рассказать об одном варианте, с которыми работаю лично, описывая по возможности недостатки и особенности остальных.

2. Мой выбор называется KVM (или Kernel-based Virtual Machine).

Подробнее об этом варианте можно почитать тут.

Но лучше все по порядку излагать. Начну с условий отбора и какие из известных мне вариантов этим условиям неудовлетворяют:

— основная система должна быть бюджетной и мощной.

В аппаратном плане я выбрал вариант AMD Phenom X4 9550 / Asus M3A78 / 2x2Gb DDR-II / 1x160Gb IDE + 2x1Tb SATA-II. Видео здесь совершенно не приципиально, кроме того, что в случае встроенной придется учитывать, что она под себя забирает часть оперативной памяти, соответственно для виртуальных машин ее останется меньше. Скажу сразу — выбор материнки с встроенным RAID-контроллером был не совсем корректным. Как выяснилось, RAID этот работает только в программном режиме, т.е. нужны драйвера для Windows систем, ну а в Linux такого же эффекта можно было достичь гораздо проще, используя стандартные средства.

Использование программной платформы для основной системы было однозначно в пользу GNU/Linux, т.к. позволяло получить среду виртуализации без лишних затрат на лицензирование, а также более облегченную в плане нагрузки (вот никогда я не пойму, почему в Windows Server без графики ничего нельзя поставить и сделать…. бессмысленная нагрузка, ИМХО). Изначально планировалось использовать вариант Ubuntu Server Hardy LTS, но почти сразу была произведена миграция на Debian Lenny (он к тому времени как раз вышел).Ни в коем случае не принижаю достоинства Ubuntu, но субьективно Debian стабильнее и быстрее работает.

— система виртуализации должна быть стабильной, общедоступной и нетребовательной к ресурсам.

От выбора разбегаются глаза, но после изучения отзывов в интернете и попыток использования сложилось субьективное мнение.

Продукты VMWare не подходят. Workstation платная, ESXi не удалось поставить на мою систему из-за неподдерживаемого чипсета (он у меня оказался более современным). Неплохим выбором был бы VMWare Server, но судя по отзывав она тяжеловата и периодически падает, сам я не стал пробовать после неудачи с ESXi. Не подошли они еще по одной причине — компания все таки продает свои продукты и только часть из них доступна в свободном доступе.

VirtualBox оказался весьма удачным вариантом. Существует в двух вариантах — OSE и Freeware. В открытом доступе исходников Freeware-версии нет, зато компенсируется это функциональностью. Из известных мне различий — это отсутствие в OSE версии поддержки USB, ограничения при работе с сетью, неподдерживается графическая акселерация (кстати, дающая весьма приличный прирост скорости работы виртуальной машины). VirtualBox идеально подходит для простейшей реализации, т.к. позволяет быстро получить работоспособную виртуальную машину без лишних телодвижений и внимательного изучения руководства. Приятной особенностью оказалась поддержка работы из консоли, что позволяет не использовать графических надстроек и соответственно снимается дополнительная нагрузка на хост-машину. Для начинающих «домашних виртуализаторов» я бы посоветовал именно такой вариант. Лично я до сих пор его использую на личном ноутбуке для быстрого поднимания тестовой среды, а также для работы в Windows (там уже давно и стабильно обосновалась Ubuntu в качестве основной системы). По субьективным ощущениям работает VirtualBox гораздо шустрее VMWare Workstation, занимает меньше места как на диске, так и в памяти. Для каждой машины выделяется отдельное окно, а также при установленных драйвера в гостевой системе (есть «из коробки») есть возможность интегрировать в рабочий стол хоста, что очень удобно и позволяет разнести задачи на разные виртуальные столы.

QEMU — очень мощная штука. Но когда вспомнил про нее, уже обратил внимание на виртуализацию на базе ядра и информацию про Xen и KVM, потому близко знакомится с чистым QEMU не стал.

Xen — идеальная система для виртуализации. Но имеет весьма существенный недостаток — гостевая система должна быть заранее подготовленна.

KVM, базируется на QEMU, по скорости почти не уступает Xen, зато обладает более гибкой функциональностью, всей мощью настроек QEMU (хотя основная часть необходимых мне была и в VirtualBOX). Оба варианта, Xen и KVM реализованы во всех современных дистрибутивах и для использования не надо прилагать серьезных усилий. Но есть между ними принципиальное отличие, о котором пойдет речь дальше.

— необходимо иметь возможность воспроизвести на виртуальных машинах различные программные платформы.

Несмотря на доступность в этом плане продуктов VMWare и VirtualBOX, от их использования я отказался еще ранее, так что рассматривать не буду… А вот применительно к Xen и KVM опишу чуток подробнее, т.к. сам искал информацию весьма долго.

Xen не позволяет запускать системы отличные от хостовой!!!, а точнее не подготовленные заранее для работы в виртуальной среде. И к сожалению (а может к счастью), подобной обработке не поддаются дистрибутивы Windows. Что меня не устраивало, потому в итоге выбор пал на варианте использования KVM, для которого заранее подготавливать гостевую систему не надо.

Итак причины выбора KVM кратко:

1. Реализация доступна из коробки в любом большом дистрибутиве;

2. Реализовано на базе ядра Linux, соответственно обладает большой скоростью;

3. Используется такими гигантами, как RedHat и Ubuntu, что говорит о высокой стабильности и гибкости;

4. Не требуется дополнительных махинаций с гостевой системой для установки в виртуальную машину.

3. Как я сделал это на Debian.

Дальше пойдет больше техническое описание, описывающее по шагам, как я сделал свой сервер, свободно тянущий с десяток виртуальных серверов.

Несмотря на то, что мой любимый дистрибутив Ubuntu, в итоге под базовую системы был выбран Debian. В рамках статьи объяснять тонкостей не буду, что да как, но на десктопе я все также предпочитаю использовать Ubuntu. Большинство инструкций для Ubuntu и Debian актуальны для обоих вариантов, потому при настройке я использовал и это и то и другое.

Итак, начнем ставить сервер.

Берем дистрибутив Debian. Чтобы не качать лишнего потом и сразу получить свежую систему, я брал вариант netinstall, при помощи которого устанавливал только вариант «Стандартная система», большего нам и не надо. Кстати, я использую 64-битный выпуск, чтобы получить поддержку большего количества оперативной памяти (>3Гб) без обходных путей и выкрутасов (к примеру, 32-битное серверное ядро дистрибутива Ubuntu поддерживает больше, чем 3Гб, но только при наличии такой возможности в чипсете).

Я использую под системные разделы («/», «/home», swap) жесткий диск IDE, дабы не иметь проблем при работе системы при установке на RAID-массив (а они есть). При установке сразу создаю RAID-1 на основе двух жестких дисков SATA для достижения большей сохранности данных (основная информация будет храниться на нем). В дальнейшем для работы с софтовым RAID-массивом следует использовать утилиту mdadm.

Свежеустановленную систему я немного ретуширую. Для начала устанавливаю ssh, чтобы можно было сразу засунуть системник подальше и отключить от него уже ненужный монитор:sudo apt-get install sshМногие советуют переключить порт с стандартного 22 на другой. Но это следует делать только в том случае, если вы уверены в своих действиях и ваш сервер подключен напрямую к интернету. Кстати, следует упомянуть, что если будет использоватся нестандартный порт, то потом возникнут сложности с удаленным управлением KVM-виртуализацией. Поэтому я оставил стандартный порт, но через аппаратный маршрутизатор сделал переброску на нестандартный, доступный снаружи.

Затем включаем синхронизацию времени через интернет (настоятельно советую, пригодится).

sudo apt-get install ntp ntpdate

Для контроля температуры чипсетов, процессора и жестких дисков:

sudo apt-get install lm-sensors hddtemp

Утилита hddtemp работает сразу, для настройки lm-sensors запускаем после установки:sudo sensors-detectотвечаем на все вопросы утвердительно.

Использовать очень просто:

— узнать температуру процессора, чипсета и других характеристик sudo sensors получаем что-то вроде:

it8712-isa-0290

Adapter: ISA adapter

VCore 1: +1.33 V (min = +3.54 V, max = +3.30 V) ALARM

VCore 2: +3.76 V (min = +1.39 V, max = +1.01 V) ALARM

+3.3V: +3.28 V (min = +4.00 V, max = +0.91 V) ALARM

+5V: +6.69 V (min = +3.04 V, max = +6.10 V) ALARM

+12V: +12.67 V (min = +15.23 V, max = +5.57 V) ALARM

-12V: -15.33 V (min = -0.85 V, max = -12.39 V) ALARM

-5V: +2.85 V (min = +3.06 V, max = +3.47 V) ALARM

Stdby: +5.99 V (min = +0.11 V, max = +6.37 V)

VBat: +3.31 V

fan1: 2922 RPM (min = 3260 RPM, div = 2)

fan2: 0 RPM (min = 5400 RPM, div = 2) ALARM

fan3: 0 RPM (min = 2732 RPM, div = 2) ALARM

M/B Temp: +44.0°C (low = -73.0°C, high = -49.0°C) sensor = transistor

CPU Temp: +32.0°C (low = -65.0°C, high = -9.0°C) sensor = transistor

Temp3: +128.0°C (low = +23.0°C, high = -66.0°C) sensor = disabled

cpu0_vid: +0.000 V

— узнать температуру 1 жесткого диска SATA — sudo hddtemp /dev/sda получаем что-то вроде:

/dev/sda: WDC WD1001FALS-00J7B0: 33°C

Для дальнейшей работы рекомендую обзавестись сторонним DHCP-сервером и на нашем сервере виртуализации настроить bridge-интерфейс.

Установим нужные утилиты: sudo apt-get install bridge-utils

Я использую в качестве DHCP-сервера свой роутер, а bridge-интерфейс создавал по инструкции. По той же инструкции рассказано, как сделать, чтобы виртуальная машина в KVM создавалась по умолчанию с использованием этого способа подключения. Для ускорения перезагрузки (совершенно не критичная ситуация, если сервер будет включен круглосуточно) советую заранее указать статический адрес на интерфейс даже при условии доступности DHCP.

И самое вкусное, устанавливаем KVM модули и полезные утилиты. Сразу добавим текущего пользователя в соответствующую группу для доступности использования KVM. Описание использования утилит можно найти по уже указанным руководствам.sudo aptitude install kvm libvirt-bin virtinst virt-top python-virtinst Фактически сразу можно использовать. Описывать все команды смысла не вижу, для этого есть man. Но покажу, как я создаю виртуальную машину:

sudo adduser softovick libvirt

для Linux virt-install -n linux -r 512 -f linux.img -s 15 -c образ.iso --accelerate --vnc --vncport=5900 --noautoconsole --os-type=linux --os-variant=generic26

для Windows virt-install -n windows -r 512 -f windows.img -s 15 -c образ.iso --accelerate --vnc --vncport=5901 --noautoconsole --os-type=windows --os-variant=win2k3 --noacpiПосле этого дальнейший ход установки и экран гостевой машины можно контролировать, подключившись при помощи VNC-клиента к серверу по порту 5900 и 5901(рекомендую для каждой машины заранее определять порт VNC, чтобы было удобно подключаться). Есть еще несколько полезных опций, я их не использую лишь потому, что не столкнулся с их необходимостью.

И еще один штрих, но не последний. Как подключить к гостевой системе возможность что-то писать напрямую на физический раздел или папку на рейде, я пока не понял, хотя и старался. Поэтому в случае Linux я подключаюсь к данным на сервере при помощи nfs, а в случае Windows — при помощи Samba. Настройка Samba достаточно тривиальна, устанавливаем sudo aptitude install samba и правим конфигурационный файл /etc/samba/smb.conf под свои задачи. А вот установка и настройка nfs не совсем тривиальна. Я использую такой вариант установки, позволяющий подключаться к нужным папкам с любого ip-адреса локальной сети (вида 192.168.10.*):sudo aptitude install nfs-kernel-server portmapПосле приведенных действий достаточно на гостевой системе сделать так:

perl -pi -e 's/^OPTIONS/#OPTIONS/' /etc/default/portmap

echo "portmap: 192.168.10." >> /etc/hosts.allow

/etc/init.d/portmap restart

echo "/media/raid 192.168.10.0/255.255.255.0(rw,no_root_squash,subtree_check)" >> /etc/exports

/etc/init.d/nfs-kernel-server reload

sudo mount сервер:/media/raid локальная_папка

При необходимости можно включить автоматическое монтирование при загрузке, поправив конфигурационный файл /etc/fstab, добавив туда строку типа:

virtual:/media/raid /media/raid nfs defaults 0 2

Ну вот, в целом настройка нашего сервера виртуализации завершена. Управлять им можно как в консоли, так и при помощи графических инструментов virsh или virtual manager.

P.S.:

Некоторые полезные советы:

1. Если вы указали конкретный порт VNC для гостевой машины, то через Virtual Manager вы не сможете автоматически запустить графическую консоль.

2. Virtual Manager не сможет подключиться, если у вас переопределен порт ssh. Точнее для этого придется долго и нудно разбираться.

3. Обязательно используйте для гостевой Windows Server режим —noacpi, чтобы она нормально установилась.

4. Аккуратно настраивайте режим сбережения энергии на гостевых системах, ни в коем случае не отключайте экран, иначе не сможете потом подключится по VNC.

5. Если вы хотите удаленно выключать и перезагружать машины через Virtual Manager, то отключайте хранитель экрана, т.к. он блокирует управление питанием.

Обзор общих записей [2009-6]

У общих записей из Google Reader есть один очень негативный момент — по ним невозможно искать! А в них оседает очень много интересной информации, которую тупо перепечатывать в блог не очень хочется. После очередного поиска в общих записях нужной мне статьи я решил, что было бы удобно сделать в блоге обзор того что за какой-то период времени в них попало. Думаю, что в качестве периода лучше всего выбрать неделю. Итак, встречайте первый обзор моих общих записей из Google Reader.

Думаю, что зачастую заголовков будет достаточно. Итак самое интересное из общих записей на данный момент:

- Ускоряем загрузки Ubuntu // ЛинСовет: Полезные Советы По Linux

- Batch convert images from the command line [Конвертирование картинок из командной строки] // Tips4Linux.com — очень интересная информация для разработчиков.

- Настройка Jabber сервера на своем домене с помощью Google apps // Хабрахабр

- Автоматизация резервного копирования в Linux // IBM developerWorks Россия

- Check your laptop battery in Linux [Проверка батарее ноутбука в Linux] // Tips4Linux.com

- Convert YouTube FLV files in Linux [Конвертирование FLV файлов с YouTube в Linux] // Tips4Linux.com

- Плагин для быстрой смены кодировки открытого файла в Gedit // Хабрахабр

- Convert CCD and IMG files to ISO in Linux [Конвертирование файлов CCD и IMG в файлы ISO в Linux] // Tips4Linux.com

- Convert BIN and CUE files to ISO in Linux [Конвертирование файлов BIN и CUE в файлы ISO в Linux] // Tips4Linux.com

- Swiftfox — альтернативная сборка Firefox // Хабрахабр — сборка заточена под конкретные процессоры и теоретически должна работать быстрее обычного FireFox.

- Apt-cacher как корпоративный сервер обновлений для Ubuntu/Kubuntu/*buntu // Хабрахабр (Резервная копия материала на narod.ru)

- Отображение ссылок с кириллицей в firefox // ЛинСовет: Полезные Советы По Linux

- A history of your Linux reboots [История перезагрузок вашего компьютера с Linux] // Tips4Linux.com

- Remove empty lines from a file [Удаление пустых строк из файла] // Tips4Linux.com

- Triple your audio volume in MPlayer [Утроенный звук в аудио файлах в MPlayer] // Tips4Linux.com

- Create a backup ISO image of your important data [Создание ISO образа с резервной копии ваших важных данных] // Tips4Linux.com

- Faster GNOME menus [Быстрое меню в GMONE] // Tips4Linux.com

Запрет обновления ядра Linux

На MSI Wind установлен WiFi модуль от Realtek. И к сожалению к нему до сих пор нет нормальных драйверов, поэтому при обновлении ядра приходится заново собирать для него драйвера из исходных кодов. Как это избежать? Очень просто — заблокируйте обновление ядра.

Откройте Synaptic [Система — Администрирование — Менеджер пакетов Synaptic]. И заблокируйте версии для следующих пакетов:

linux-libc-dev

linux-restricted-modules-common

linux-restricted-modules-generic

Для этого выделите нужный пакет и выберите пункт меню [Пакет — Заблокировать версию]:

Теперь при проверке обновлений через Менеджера Обновлений на его заявление о том что Не все обновления возможно установить отвечайте кнопкой Закрыть и после этого можно щёлкнуть на кнопку Установить обновления.

Всё. У меня так система работает с октября 2008 года.

Трюки в bash

Те кто перешёл на Linux скорее всего уже не раз использовали командную строку для установки или настройки чего либо. В начала мне, как и всем кто был воспитан на Windows, такой способ управления компьютером казался очень сложным и не правильным. Но чем больше я работал с терминалом, тем больше я понимал всё удобство работы именно таким способом.

Особенно удобно стало работать в терминале, когда я узнал о специальных командах bash.

История и bang-bang

История команд — очень удобный инструмент. С помощью стрелок вверх-вниз можно перемещаться по истории введённых команд. Кроме того, с помощью команды history можно просмотреть всю историю команд:

190 ps axu | grep htt

191 /www/bin/apachectl start

192 vi /usr/local/lib/php.ini

193 cat /www/logs/error_log

194 ps -auxw | grep http

195 pwd

Ничего удивительного.

Гораздо интереснее то, что называется bang-bang, или команда !!

!! означает последнюю команду в истории. Т.е. ввод !! в данном случае аналогичен вводу pwd.

Но и это еще не все. Можно ввести ! . ! ps в данном случае вызовет ps -auxw | grep http. Но будьте внимательны и сообщайте восклицательному знаку достаточно символов команды. Например ! p в данном случае будет аналогично pwd, а не ps -auxw | grep http (поскольку pwd ниже в истории) как возможно хотелось бы.

: p не просто смайлик

Для того чтобы избежать конфузов при использовании ! можно добавлять к нему смайлик : p. Это заставит bash вывести то, что он собирался выполнить. Кроме того, : p достаточно умен для того, чтобы добавить выведенную команду в историю.

В качестве примера:

! ps: p в нашем случае вернет ps -auxw | grep http. Убедившись что это именно то что нужно, можно ввести !! и bash выполнит ps -auxw | grep http.

Другие способы использования истории

Наверное самый примитивный способ — вызвать команду history, узнав номер необходимой команды, а затем использовать ! N, где N — номер команды в истории (например, !192). Не следует пренебрегать этой возможностью. Иногда запомнить !123 для какой-то постоянно нужной команды гораздо проще чем пользоваться другими способами.

Кстати, : p работает и тут.

Еще один удобный способ — нажать ^r (Ctrl-r) и начать вводить первые символы нужной команды. bash будет искать в истории подходящие команды.

Работа с агрументами

!$ (bang-dollar) означает последний аргумент последней команды.

К примеру тут:

ls /some/long/path/to/dir/

rm -rf !$

В результате выполниться команда rm -rf /some/long/path/to/dir/.

Кстати, : p тут тоже работает.

!* похожа на !$, но превращается во все аргументы последней команды.

Шапочки

Наверняка вы не раз вводили что-то типа

vi /etc/X22/xorg.conf

Это очень легко поправить с помощью шляпок:

^22^11 заменяет 22 на 11 в предыдущей команде. По аналогии всегда можно использовать ^ошибка^исправление.

Автодополнение

Ну и разумеется не стоит забывать про автодополнение. Один Tab дополняет команду насколько можно понять, второй выводит все варианты дальнейшего написания. Однако не следует этим злоупотреблять. Согласитесь, написать less быстрее, чем написать le и долбить по табу.

Алиасы

Полезно дать короткие имена часто используемым командам. Также полезно дать алиасы наиболее частым опечаткам.

Полезными алиасами могут быть:

alias ls='ls --color=auto'

alias mroe='more'

alias H='kill -HUP'

alias ssh-production='ssh www.myproject.com'

alias ssh-qa='ssh qa.myproject.com'

alias sl='ls'

Установка и настройка Linux Mint Elyssa R1

Недавно я прочитал в ленте новостей о новой сборке Linux Mint, которая основывается на Ubuntu Linux 8.04 и полностью с ним совместима. По заявлению разработчиков они всего лишь изменили несколько устанавливаемых по-умолчанию пакетов и незначительно переработали интерфейс.

Недавно я прочитал в ленте новостей о новой сборке Linux Mint, которая основывается на Ubuntu Linux 8.04 и полностью с ним совместима. По заявлению разработчиков они всего лишь изменили несколько устанавливаемых по-умолчанию пакетов и незначительно переработали интерфейс.

Linux Mint, так же как и Ubuntu Linux имеет LiveCD и перед установкой можно посмотреть на то как будет выглядеть система после инсталяции на жёсткий диск. Но в отличие от Ubuntu Linux Mint пока имеет только Gnome в качестве среды рабочего стола.

Интерфейс по-умолчанию разработчикам видимо очень хотелось подогнать под Windows.

Но для меня интерфейс Ubuntu намного удобнее. Поэтому я его изменил, благо в Linux это делается парой кликов мыши.

Меню в Linux Mint идентично меню в OpenSuse:

Изначально оно кажется очень удобным, но после некоторого времени работы с ним я понял, что трачу больше времени для запуска приложений, нежели используя меню из Ubuntu, поэтому я вернулся к меню из Ubuntu.

Ну а теперь про дополнительные пакеты в Linux Mint:

- EnvyNG который помогает установить драйвера для видео карты

- Gnome Do, который помогает быстро искать нужные приложения и документы (Do things as quickly as possible (but no quicker) with your files, bookmarks, applications, music, contacts, and more!)

- mintDesktop, который помогает вывести на рабочий стол привычные пользователям Windows ссылки (Компьютер, Домашняя папка, Сеть, Корзина, Подключенные накопители)

- APTonCD, который помогает создавать ISO образы с установленными пакетами, а потом восстанавливать пакеты в другой системе.

- Windows Wireless Drivers, который поможет установить в Linux драйвера для WiFi из Windows

- Ещё есть пакеты «Выбор мультимедийной системы», «Настройка действий в Nautilus», mintAssistant, mintBackup, mintInstall, mintUpdate, а так же те которые я за день работы не заметил

А вот чего не найти в системе после установки так это игры, но это же не проблема ведь есть Synaptic.

P.S.

Если кто не хочет мучаться с обновлением до последней (на 6 июля 2008) версии пакетов системы и установкой русскоязычных пакетов, а также необходимых пакетов (java, msfonts и т.д.), то может скачать сделанный мной при помощи APTonCD ISO образ и восстановить его при помощи всё того же APTonCD.